在之前的向量代数-线性映射和线性代数-向量空间笔记中,我尝试了以简单语言和逻辑描述了向量空间的定义和线性映射的定义。 在这篇笔记中,我将会尝试以最简单的又不脱离基本的数学定义来说明矩阵的特征值和特征向量。

特征值和特征向量

在之前的笔记中,我提到过子空间的概念,我们来回顾一下这个概念:

一个向量空间\(V\)的子空间\(U\)定义为: \(U\)是\(V\)的一个子集,且\(U\)也是一个向量空间。

这个定义很简单,它给出了子空间概念的两个关键: - 是某个向量空间的子集 - 本身也是向量空间

同时,在另外一篇笔记中,我们也说明了线性映射的概念: 线性映射就是一个将向量从一个空间映射到另外一个空间的函数,且这个函数满足两个特殊的条件.

现在,我们来考虑一种特殊的线性映射: 将向量映射到自身空间的线性映射。 我们用\(\mathcal{L}(V)\)表示\(\mathcal{L}(V,V)\). 这种特殊的线性映射我们称为算子(Operator). 这种特殊的线性变换非常重要,因为它将我们面对的问题限定在同一个向量空间中。 可以知道,一个算子对应的矩阵表示一定是\(n\times n\)的一个方阵(\(n\)向量空间的维度)

OK,我们现在知道了子空间和算子是什么了。

如果把这两个概念结合起来,我们就能给出不变子空间的定义:

如果\(T\in \mathcal{L}(V)\)且\(U\)是\(V\)的一个子空间,\(U\)中的任意一个元素经过\(T\)映射之后,依然是\(U\)的元素,那么\(U\)就被称为不变子空间.

也就说,\(U\)中的元素经过\(T\)的映射之后,依然是\(U\)的元素。而\(T\)是定义在\(V\)上的线性映射。 我们此时关心的其实不是所有的不变子空间,我们在意的其实只是维度为\(1\)的不变子空间。

我们可以将维度为\(1\)的子空间表示为:

注意,这只是一个维度为\(1\)的子空间,它还不是不变子空间。 那么,如果我们想要它变为一个不变子空间呢?那么根据不变子空间的定义,那么一定存在一个\(\lambda\)使得:

而此时上述等式中的\(v\)和\(\lambda\)就被称为特征向量和特征值。

Ok.我现在来梳理一下概念的流程:

根据向量空间和线性映射的定义,我们特别指出了一种特别的线性映射: 算子。算子是将向量映射到自身空间的线性映射。 然后,通过子空间的定义,我们又给出了不变子空间的定义。 而,特征向量其实描述的就是某个线性空间中的维度为\(1\)的不变子空间。

这个可能有点绕,更加直观的解释是,一个向量经过\(T\)的映射之后,方向不变。 只是改变了长度,这样的向量就被称为特征向量。

根据这些定义,我们可以知道: 1. 每一个特征向量其实描述的就是当前线性空间中的维度为\(1\)的不变子空间。 2. 特征向量只会发生在方阵身上,因为特征向量是定义在算子上的,而算子的矩阵表示一定是一个方阵。

特征值和特征向量的物理意义

那么,我们又有疑问了,数学家们为什么要定义出特征向量和特征值呢?他们为什么如此重要,以至于我们需要给他们一个特殊的名字呢?

在回答这个问题之前,我们先来看一下,特征向量有哪些性质。 最重要的一条性质,就是特征向量之间都是线性无关的。 这是非常重要的一条性质,还记得我们曾在该系列的第一篇文章中指出,一组向量如果线性无关,那么该向量空间中的任意一个元素都能被这组线性无关的向量表示。

这个性质就非常棒了。 也就是说,\(V\)中的任意一个元素都能被这组特征向量表示。

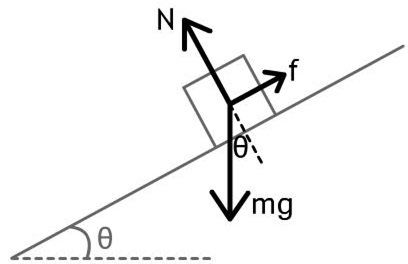

仔细想想,定义在\(V\)上面的线性算子\(T\)本质描述的其实就是一种映射,一种运动。而这种运动一定是由方向和大小组成的。 回忆一下,我们高中做过的物理题目。 当我们为一个物体做受力分析的时候,我们需要考量的是什么?我们需要考虑就是力的方向和大小。 还记得我们是怎么分析的吗?对于一个力,通常的做法是将其进行分解,分解成多个方向上的分力,然后对分力进行单独分析。

而此处的特征向量其实做的是类似的工作,特征向量就像受力分析中的分力。 线性映射\(T\)描述的运动的方向,可以分解为多个特征向量。 \(T\)所描述的运动在这些方向上的前进大小是最大的,因此这些特征向量才如此重要。

这样,我们就可以做出如下的类比关系: 1. \(T\)就是物理习题中需要的分析的一个受力方向 2. 但是这个受力方向太过复杂,一时之间我们无法理解。那么我们将其分解为重力方向、摩擦力方向等等各种不同的方向。而矩阵的特征向量就像是这些各个方向上的分力方向.

之所以能把特征向量看成是“分方向”,是因为这些特征向量是相互线性无关的,因为就能够描述任意一个空间中的向量。 而所谓的特征值,就是对应的特征向量方向上的前进距离,可以类比为各个分力方向上的分力大小。 由此,更进一步,我们就可以知道,这个分力越大,就说明这个方向上的权重就越大,包含的信息就越多。 因此,特征值分解常常作为信息压缩的方法。

当然,最后需要指出的是。 在这个类比中,分力的方向其实不止一种。 也就说,特征值分解只是矩阵分解中的一种。 还存在其他的分解方式,能达到同样的效压缩信息的作用。 比如SVD分解 。

参考资料

更新日志

- 2018年7月29日写作并发表

Comments

So what do you think? Did I miss something? Is any part unclear? Leave your comments below